«La

mente umana è profondamente legata all'irrazionale». Sono le parole

dello psicologo Bruce Hood della Bristol University. Secondo lo

studioso si ha nell'essere umano una vera e propria tendenza

all'irrazionale, che prende forma fin dalla prima infanzia. Con ciò

risulta alquanto riduttivo tentare di mettere al bando credenze

magiche e religiose: faranno da sempre parte della natura umana.

«Sono parte integrante della nostra mente», dice Hood. «Credo,

pertanto, che sia ottusa pensare che sia possibile indurre la gente

ad abbandonare i propri sistemi di credenze, e non c'è evidenza

scientifica che tenga». In sostanza non è vero che esistono persone

razionali e irrazionali: esistono solo individui che gestiscono in

modo diverso la propria irrazionalità. Il fenomeno è una

prerogativa della natura umana, laddove da sempre l'uomo si trova

nelle condizioni di decidere in fretta e furia cosa fare (o non

fare), spesso facendosi guidare dall'istinto o dalle emozioni,

parametri che lasciano ben poco spazio al meccanicismo del razionale.

Ecco perché non stupisce sapere dell'esistenza di una (geniale)

tavola periodica dell'irrazionale con tutte le varianti del caso:

cerchi del grano, telepatia, numerologia, astrologia, vampirologia,

fantasmi, occulto... rigorosamente suddivisa in sezioni:

extraterrestri, pseudoscienze, medicina alternativa, religione...

mercoledì 31 agosto 2011

martedì 30 agosto 2011

2031, primo contatto alieno

Ogni tot i russi tornano con una delle loro sparate, che anche a noi, tutto sommato, non dispiace cavalcare. L'ultima riguarda uno degli argomenti (pseudo)scientifici più controversi: la scoperta degli extraterrestri. Stando infatti alle indiscrezioni fornite da Andrei Finkelstein, direttore dell'Istituto di Astronomia Applicata presso l'Accademia Russa delle Scienze, incontreremo ufficialmente gli alieni entro il 2031. “La genesi della vita è inevitabile come la formazione di atomi”, dice lo studioso. “La vita esiste sui pianeti e lo scopriremo entro 20 anni”. Lo scienziato è arrivato a queste conclusioni constatando che il 10% dei pianeti conosciuti intorno alle stelle della Via Lattea, è simile alla Terra, e dunque potenzialmente in grado di ospitare vita, anche evoluta: Finkelstein azzarda che gli alieni possano essere molto simili agli umani, caratterizzati quindi da due braccia, due gambe e una testa. “Possono avere diverso colore di pelle, ma anche noi lo abbiamo”, ha replicato. L’Istituto di Finkelstein guida un programma lanciato negli anni ’60 nel periodo della corsa allo spazio innescatesi durante la Guerra Fredda, con lo scopo di inviare segnali radio nello spazio esterno. “Per tutto il tempo in cui abbiamo cercato civilizzazioni extraterrestri, abbiamo principalmente atteso messaggi dallo spazio e non viceversa”, ha commentato Finkelstein, sottolineando la necessità di muoverci noi in prima persona per ottenere un primo contatto alieno. Anche la NASA ogni tanto torna a sperare nella possibilità di incontrare entro breve civiltà aliene. Lo dimostra l'enfasi con cui vengono diramate le notizie riguardanti la scoperta di forme di vita riconducibili ad altri pianeti. Qualche mese fa, per esempio, è stato pubblicato l'annuncio del ritrovamento di un batterio fossile all'interno di un meteorite. Mentre s'è appurato che è possibile risalire a forme di vita con un DNA del tutto diverso dal nostro: la scoperta riguarda un microrganismo in grado di vivere in situazioni estreme, cioè nell'arsenico. L'argomento come al solito va preso con le pinze, poiché è noto che in tema di ET tutti tendano a “spararla grossa”. In alcuni casi si è arrivato addirittura a ipotizzare che gli extraterrestri siano già fra noi. Ne è convinta l'autrice del blog “Noi e gli extraterrestri” che sostiene di avere avuto esperienze di contatto dirette con gli alieni, i quali starebbero influenzando l'evoluzione della coscienza umana per cercare di portarla a un livello superiore.

|

| Una scena del film ET |

RAZZE ALIENE (da Brad Steiger, 1980)

ALFA

Sono

umanoidi alti fra i 50 cm e il metro e mezzo, con crani assai

sviluppati, pelle bianca o grigia, assenza di peli, nasi piatti,

occhi lunghi e ovali neri (o protetti da speciali lenti scure),

bocche a fessura senza labbra. Sono comunemente denominati "Grigi",

questi alieni sono esili, con arti allungati e un numero di dita che

varia da tre a sei, secondo le diverse relazioni di incontro.

BETA

Denominati

Fratelli dello Spazio, identificati dai contattisti con forme

angeliche scese sulla Terra per riportare l’umanità nell’amore

universale. Secondo alcuni, Cristo sarebbe stato un alieno di tipo

beta. Il loro aspetto è simile al nostro, ma sono tutti bellissimi,

alti, quasi sempre biondi con gli occhi chiari.

BETA II

Sono

umanoidi dalla pelle olivastra e gli occhi a mandorla, ambigui,

selvaggi e oscuri, sono i nemici naturali dei beta. Alcuni studiosi

li hanno ribattezzati MIB (Men in Black, Uomini in Nero).

BETA F

Sono

creature spirituali, dotate di aura intorno al corpo o di un'alone

luminoso intorno al capo, che appaiono ai mistici e ai sensitivi e

scambiati talora per la Vergine Maria o Santi vari.

GAMMA I

Sono

umanoidi conosciuti da lungo tempo sul nostro pianeta; di loro sono

piene le leggende di tutti i popoli. Yeti, Bigfoot, Gremlins,

Critters...

DELTA I

Sono

alieni non umanoidi, ma simili a insetti, rettili, anfibi,

pipistrelli oppure mostri dagli aspetti orribili.

Boeing 747-8: pronto al decollo

Il nuovo Boeing 747-8 Freighter è pronto per il primo volo ufficiale. Ha infatti ricevuto la certificazione sia dalla Federal Aviation Administration (FAA) statunitense che dall’Agenzia Europea per la Sicurezza Aerea (EASA) superando così due degli ultimi traguardi per l’entrata in servizio. Con questi certificati è prevista la consegna del primo esemplare a Cargolux, il cliente di lancio, ai primi di settembre. La FAA ha concesso un Amended Type Certificate (ATC) – emendamento al certificato che approva il modello 747-8 Freighter e un Amended Production Certificate (ATC) - emendamento al certificato di produzione che attesta la correttezza delle procedure per la produzione, mentre la EASA ha concesso un ATC. Celebrando le certificazioni, avvenute venerdì, Jim Albaugh, presidente e CEO di Boeing Commercial Airplanes ha detto: "E’ una grande giornata; negli ultimi anni la squadra ha superato sfida dopo sfida. L’arduo lavoro di tutti ha assicurato che il 747, la Regina dei Cieli, voli per decenni a venire”. "La spinta per arrivare alla certificazione è stata uno sforzo dell’intero team" ha detto Elizabeth Lund, vice presidente e direttore generale del programma 747. Con gli ATC (Amended Type Certificate) la FAA e l’EASA attestano che il progetto del 747-8 Freighter è conforme a tutti i regolamenti per la sicurezza e l’affidabilità degli aerei. L’aereo ha effettuato oltre 3.400 ore di volo nel programma di collaudi mentre altrettante migliaia di ore di prove sono state condotte a terra, su componenti e materiali, per arrivare alla certificazione. Il Certificato per la produzione dell’FAA attesta che l’Ente ha convalidato che il sistema di produzione del Boeing 747 è tale che gli aerei prodotti saranno conformi al progetto. Per l’EASA i certificati FAA relativi alla produzione di aerei Boeing sono sufficienti per il rispetto dei suoi regolamenti, così come per la FAA sono sufficienti i certificati dell’EASA relativi agli aerei prodotti in Europa. Il 747-8 Freighter è il nuovo 747 (“Jumbo”) ad alta capacità che fornirà agli operatori cargo i più bassi costi operativi e le migliori caratteristiche economiche di tutti gli aerei cargo, con la migliore performance ambientale. E’ lungo 76,3 mt – 5,6 mt in più rispetto al jumbo precedente – il 747-400 Freighter. L’allungamento incrementa del 16% il volume cargo, pari a quattro pallet aerei sul piano principale e tre ulteriori pallet nelle stive inferiori.

giovedì 11 agosto 2011

Standard & Poor' declassa gli USA

Per la prima volta nella storia, gli USA sono stati declassati dalla Standard & Poor's, la principale agenzia di rating americana che valuta l'affidabilità finanziaria di Stati e aziende private. Da AAA, il voto più alto, quello delle economie più stabili (Canada, Germania, Francia), gli USA sono scesi a AA+. L'Italia vale A+, mentre l'unico paese giudicato con la lettera C (il voto più basso è la D) è la Grecia. Una decisione senza precedenti, che minaccia di destabilizzare ulteriormente i mercati, trasformando così la crisi del debito sovrano da crisi sinora solo europea in crisi globale. L'agenzia ha affermato che a suo giudizio «il piano di consolidamento fiscale del Congresso non contiene ciò che è necessario per contenere il debito a medio termine», lamentando «l'inefficienza delle istituzioni» di fronte alla crisi. Standard & Poor' s ha anche ammonito che «l'outlook è negativo», cioè che le prospettive economico-finanziarie americane rimangono inquietanti, e non ha escluso un altro declassamento tra 12-18 mesi «in mancanza di correzioni solide». Lo shock ha coinvolto mezzo mondo. Fra i paesi più contrariati dal declassamento USA c'è la Cina, vera nuova potenza economica mondiale: «Al di fuori degli Stati Uniti molti ritengono che il taglio di rating sia un conto da tempo atteso che l’America deve pagare per la crescita del debito e per le miopi dispute politiche a Washington», commenta in una nota il Governo cinese, che tra l’altro è tra i maggiori creditori di quello statunitense e per la svalutazione del dollaro subirebbe ingenti perdite.

mercoledì 10 agosto 2011

Scritti corsari: la storia della macchina da scrivere

Una rivoluzione innescatesi a metà dell'Ottocento: la macchina da scrivere. Con essa si ha per la prima volta la possibilità di redarre testi e documenti con facilità e celermente. Ma la sua storia sta per tramontare: pochi mesi fa, infatti, ha chiuso l'ultima azienda che fabbricava macchine da scrivere, sopraffatta dalla crisi e dal definitivo sopravvento dei computer. Ma la la sua evoluzione non è stata vana: ancora oggi, infatti, pc, iPad e telefonini, si avvalgono del cosiddetto schema di scrittura QWERTY, inventato 150 anni fa da un ingegnoso americano

Fino a un paio di decenni fa, avere una bella calligrafia, era una prerogativa importante. Scrivere con eleganza, precisione e meticolosità, significava poter dar lustro di sé e delle proprie potenzialità professionali e consentire al lettore non solo di leggere agevolmente, ma anche di godere di una forma artistica riconducibile al disegno. Oggi, però, quasi nessuno è più in grado di scrivere con tanta maestria: l'avvento dei computer ha completamente rivoluzionato i criteri di scrittura, relegando biro, penne e pennini a oggetti obsoleti, in grado semmai di farci perdere del tempo prezioso. Con essi anche le macchine da scrivere hanno subito un duro contraccolpo, dopo oltre cento anni di onorata carriera. Il colpo di grazia, un paio di mesi fa, con la chiusura, in India, dell'ultima azienda produttrice di macchine da scrivere. La Godrej and Boyce di Mubai ha, infatti, dichiarato bancarotta dopo anni di crisi, benché i loro prodotti venissero utilizzati negli uffici statali fino a pochi mesi fa. Una svolta epocale, che sancisce definitivamente il passaggio dallo scrivano tradizionalista, Bic od Olivetti dipendente, a quello hi-tech, agile solamente davanti a touch-screen e tastiere digitali. Ma come si è arrivati fin qui? Risale agli inizi dell'Ottocento il primo tentativo di rivoluzionare i sistemi di scrittura, con il pavese Pietro Conti che costruisce il cosiddetto “tachigrafo”. Si basa sull'impiego di leve e tasti, corrispondenti alle varie lettere dell'alfabeto. Lo esibisce con successo presso l'Accademia di Francia, giustificandolo come lo strumento ideale per “far scrivere tutti velocemente”. Viene acquistato in Francia per 600 franchi, aprendo la strada ad altri prodotti simili. Celestino Galli, erudito cuneese, realizza, per esempio, il “potenografo meccanico” o “clavicembalo scrivano”, macchinario rappresentato da tasti posizionati su due cerchi concentrici: con una mano si stampano le vocali, con l'altra le consonanti. Sfonda soprattutto in Inghilterra, dove chiunque ne parla con entusiasmo. “Dotato di un meccanismo molto ingegnoso, permette di scrivere con la stessa rapidità con cui si parla”, racconta una pagina del Times del 27 giugno 1831. Due anni dopo il francese Xavier Progin progetta la prima macchina da scrivere equipaggiata con una tastiera a tutti gli effetti, riconducibile a quelle moderne. La Plume Ktypographique è formata da 66 leve articolate, disposte a circolo, riportanti le varie lettere dell'alfabeto e i segni di punteggiatura; le leve possono anche essere sostituite per consentire la battitura di partiture musicali. L'obiettivo dell'avvocato novarese Giuseppe Ravizza è, invece, realizzare uno strumento che consenta ai ciechi di scrivere. Prende spunto dai lavori compiuti da Pierre Foucault, collaboratore di Louis Braille, che ha da poco ideato il rapigrafo, prodotto meccanico con dieci leve disposte a ventaglio, perfetto per facilitare l'attività di scrittura dei non vedenti. Nasce così nel 1846 il cembalo scrivano, l'antenato di tutte le macchine da scrivere, battezzato in questo modo per la sua somiglianza con la tastiera di un pianoforte. Brevettato nel 1855, è contraddistinto da seicento pezzi di legno, un centinaio in ottone, una rudimentale tastiera orizzontale, un nastro impregnato di inchiostro. Non è maneggevole, ma è molto funzionale e in breve tempo – soprattutto dopo le esposizioni industriali di Novara e Torino del 1856 – si propone come l'oggetto più indicato per cambiare radicalmente le sorti professionali di scrittori, giornalisti, poeti, amministratori, politici. Lo stesso Ravizza battezza sedici nuovi modelli, benché nessuno di essi trovi la strada per la diffusione su larga scala. Ma il destino delle nuove macchine da scrivere è ormai tracciato.

Lo conferma l'esperienza dello statunitense Christopher Latham Sholes che, affiancato dai tipografi Samuel Soulè e Carlos Glidden, brevetta un modello di macchina che ricorda in modo palese la proposta di Ravizza, ma che riesce a far breccia nel mondo industriale. Mentre è del tutto solitaria e isolata l'esperienza del tirolese Peter Mitterhofer, che nel villaggio di Parcines, fin da ragazzino dà sfogo alla sua ingegnosità, per giungere nel 1864 a una macchina da scrivere assolutamente originale, quasi interamente realizzata in legno. Si reca per due volte a Vienna con l'intento di incontrare l'imperatore Francesco Giuseppe I, per chiedere sovvenzionamenti per la sua invenzione; ma l'entourage del leader austriaco non comprende il valore della sua proposta e lo manda a casa a mani vuote. Mitterhofer muore abbandonato da tutti e solo oggi viene riconosciuto il valore del suo lavoro. Le macchine da scrivere assumono i connotati di quelle attuali a partire dal 1873. The type writer è fra i modelli cult di Sholes; presenta una tastiera composta da 45 tasti disposti su quattro file, con leve portacaratteri circolari, carrello ribaltabile a cerniera per poter leggere comodamente ciò che si è appena scritto. L'inventore, originario della Pennsylvania, incontra Philo Remington, industriale newyorkese che decide di appoggiarne l'idea, consentendo di diffondere in tutto il mondo l'avveniristico prodotto. Fra i collaboratori di Remington c'è l'ingegnere George Yost che propone la Caligraph, la prima macchina da scrivere in grado di alternare minuscolo e maiuscolo e dotata della barra spaziatrice. Nel 1908 è l'Italia a entrare nel vivo della storia delle macchine da scrivere con Camillo Olivetti che fonda a Ivrea, nel torinese, una società. Nel 1911 viene messo in commercio il primo modello, denominato M1. Viene pubblicizzato con grande enfasi, coinvolgendo Teodoro Wolf Ferrari, noto pittore veneziano, che l'illustra fra le mani di un serioso Dante Alighieri. L'attenzione è riservata anche al design: «Una macchina da scrivere non deve essere un soprammobile, sovraccarico di elementi decorativi. Deve avere un aspetto sobrio e allo stesso tempo funzionale», rivela lo stesso Olivetti. Rispetto ai vecchi modelli la M1 consente l'inversione automatica del nastro e l'azione di una leva particolare per impedire l'uscita dai margini. Il suo successo è prevedibile e fra il 1911 e il 1920 vengono vendute 6mila M1. Rimane un problema: gli errori. Nonostante l'abilità dei dattilografi è, infatti, facile sbagliare, scambiare una lettera per l'altra, uscire dai bordi, utilizzare il maiuscolo al posto del minuscolo. Ma a questo limite si può ovviare con l'uso del “bianchetto”, che consente di cancellare il refuso e riscrivere correttamente la parola sbagliata. Bisogna, dunque, aspettare qualche decennio prima di ottenere le prime macchine da scrivere con incorporata la cosiddetta “modalità sbianca errori”, stratagemma che permette di risolvere le “sbavature” azionando un semplice tasto. È il 1961 e IBM coglie anche l'occasione per modificare il sistema di battitura tradizionale introducendo l’elemento mobile di scrittura, una pallina di materiale plastico rivestita di metallo, con impresse le lettere; è intercambiabile e consente di scegliere il carattere appropriato al documento che si intende redarre.

Ma perché, nonostante i raffinamenti della tecnica, le lettere delle tastiere restano disposte nello stesso modo? E ancora oggi, con computer, smartphone e cellulari, continuiamo a beneficiare del medesimo sistema di scrittura? La risposta è semplice: perché non si è ancora trovato un modo per poter “battere a macchina” più velocemente. Si chiama QWERTY ed è lo schema di posizionamento dei tasti più gettonato in assoluto. Le lettere che lo rappresentano corrispondono alla prima riga in alto, partendo da sinistra, di una qualunque tastiera con la quale siamo soliti confrontarci: macchina da scrivere, computer, iPad. Risale al 1873 e alle prime geniali intuizioni di Sholes, convinto che le lettere maggiormente usate debbano stare il più lontano possibile fra loro: solo così, infatti, si evitano “pericolosi” incroci fra le dita, che anziché velocizzare la scrittura, la rallenterebbero. Sholes pensa a tutto e sotto la lettera F e la lettera J ci infila un trattino sensibile al tatto, che permette di capire in quale punto della tastiera ci si trova, senza la necessità di vederla. Il brevetto viene venduto alla Remington, che introduce il sistema di scrittura di Sholes senza modificarlo di una virgola, rendendolo noto in tutto il mondo. Le tastiere standard, però, possono non essere del tutto funzionali con i sistemi operativi Windows, con dei limiti per gli accenti delle vocali maiuscole, che possono essere ottenuti solo adottando stratagemmi particolari, come digitare dopo un punto la lettera accentata minuscola, per guadagnarne la maiuscola; mentre con Linux, il problema viene risolto usando la minuscola accentata e cliccando il tasto Claps Lock. Altrettanti problemi possono verificarsi in seguito alla lingua utilizzata dal possessore di una machina da scrivere. Ma anche in questo caso s'è giunti a soluzioni in grado di soddisfare un po' tutti, sviluppando delle piccole modifiche del modello standard. Nelle tastiere tedesche, per esempio, Z e Y vengono invertite, poiché in Germania la Z è molto più utilizzata della Y; inoltre le due lettere, nel linguaggio corrente, si trovano spesso appaiate. Perciò le tastiere tedesche sono state battezzate QWERTZ. Nel corso della storia, però, sono stati tentati anche approcci diversi, per cercare di trovare un'alternativa allo schema QWERTY. La proposta più interessante è di August Dvorak, che nel 1936 inventa la cosiddetta “sistemazione semplificata di Dvorak”. Ancora oggi c'è chi è convinto che questo sistema consenta di scrivere il più veloce possibile, benché scienziati come Stan Liebowitz dell'University of Texas sostengano il contrario; ma una donna di nome Barbara Blackburn è stata inclusa nel Guinness dei primati per essere riuscita a scrivere 150 parole al minuto per cinquanta minuti proprio grazie a una tastiera Dvorak. Si basa sul posizionamento centrale di tutte le lettere più utilizzate; le vocali, per esempio, si trovano una dopo l'altra lungo la seconda linea partendo dalla sinistra della tastiera, mentre le ultime lettere dell'alfabeto, V, W, Z, si posizionano in corrispondenza dell'ultima riga in basso a destra. È una tastiera studiata per la lingua inglese, perciò utilizzandola in Italia si verrebbero a creare dei problemi dovuti al fatto che gran parte delle nostre parole terminano con a, e, i, o, u.

Ma non tutta la tecnologia che oggi ci permette di scrivere è figlia dell'ingegno di Sholes. Per esempio il mondo dei cellulari e dei touch screen obbedisce a un sistema di scrittura del tutto particolare, chiamato T9, che solo in parte ha a che vedere con lo schema QWERTY: le lettere, infatti, possono anche essere disposte una dopo l'altra, seguendo l'ordine prestabilito alfabeticamente. È un software tarato appositamente per agevolare la scrittura; in questo caso specifico, un predictive text, realizzato da Tegic Communication, assimilabile a iTAP impiegato da Motorola e LetterWise proposto da Eatoni. Il sistema T9 conquista il mercato nel 2005, consentendo ai possessori di telefonini di spedire messaggi, comporre numeri e nomi a gran velocità; la prima azienda a utilizzarlo è la finlandese Benefon. La sua efficacia è garantita da un dizionario integrato che associa determinati clic a potenziali parole; in realtà, in molti casi, il lemma selezionato non è presente nel paroliere virtuale e dunque è necessario digitare una lettera alla volta. Una quarantina le lingue attualmente supportate dal software. Nonostante il suo successo, però, secondo alcuni esperti informatici, la sua esistenza è al capolinea. Ha già fatto il suo ingresso a livello internazionale, infatti, un nuovo sistema per la digitazione veloce, ideale per tastiere virtuali e touch-screen. Battezzato Swype è stato realizzato dagli stessi tecnici del T9. La conferma della sua efficacia è conferita dal fatto che il messaggio più veloce mai spedito da un telefonino - registrato dal Guinness dei primati - è avvenuto proprio con questa forma di scrittura. Usufruisce della cosiddetta logica vettoriale, vale a dire un sistema che consente di far scorrere il dito (o il pennino sul display) da una lettera all'altra, così da comporre la parola desiderata, senza mai spostarsi dalla tastiera; in caso di errore, come in T9, interviene il dizionario digitale per le correzioni. Altrettanto efficace BlindType, sistema di scrittura in grado di eliminare quasi del tutto il rischio di commettere errori mentre si digitano parole e locuzioni. Anche qui è “l'anima” del software a indovinare le intenzioni dell'utente, grazie alle impostazioni dettate da una sequenza algoritmica. «Sappiamo che la digitazione sui dispositivi mobile può essere un'esperienza frustrante», dicono gli inventori di BlindType, «ed è per questo che abbiamo lavorato sodo per rendere la scrittura su touch più facile e veloce che mai, cioè come dovrebbe essere».

lunedì 8 agosto 2011

27 anni da rockstar: un mito da sfatare

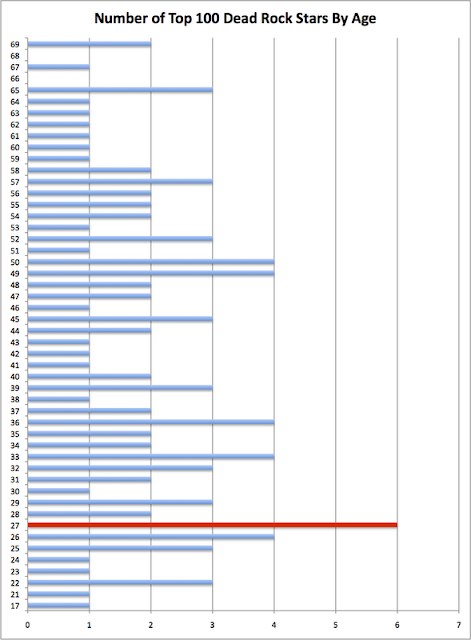

La triste e improvvisa dipartita della cantante Amy Winehouse porta di nuovo al famoso dibattito relativo al fatidico compimento del ventisettesimo anno di età: davvero questo traguardo è associabile statisticamente al maggior numero di morti fra le rockstar? A 27 anni sono, infatti, deceduti Brian Jones (Rolling Stones), Jim Morrison (The Doors), Jimi Hendrix, Janis Joplin e Kurt Cobain (io aggiungerei anche Robert Johnson)... Ora un sito inglese - http://www.crispian-jago.blogspot.com/ - cerca di svelare l'arcano mistero elencando 100 figure cult dell'universo rock e sviluppando un grafico (1) evidenziante l'età più critica per le rockstar. In effetti, dal consequenziale grafico 2, emerge che in corrispondenza del 27esimo anno il numero di decessi è superiore a quello di tutte le altre età: ce ne sono ben sei. A seguire con 4 dipartite cadauno le seguenti età: 26, 33, 36, 49, 50. In realtà, si evince dal sito, questo dato non prova statisticamente nulla, anzi: supponendo di aumentare il campione da cento a mille rockstar, probabilmente la linea dei ventisettenni sarebbe molto meno significativa. Il fenomeno è probabilmente dovuto al fatto che – in corrispondenza del 27esimo anno di età – dopo vari anni di vita all'insegna di sesso, droga e rock 'n' roll, un organismo è più facile che soccomba agli stravizi. Tutto qua. Alla luce di ciò è possibile affermare che non esistono prove “scientifiche” a favore della tesi “maledetta” del club 27, se non la voglia di rendere ulteriormente affascinante il mondo della musica leggera.

|

| Grafico 1 |

|

| Grafico 2 |

UNIVERSI MELLIFERI

|

| Rappresentazione grafica dell'effetto geodetico |

Un satellite in orbita dal 2004 dimostra che le teorie espresse da Albert Einstein erano corrette: la luce, in prossimità di un corpo pesante, devia in funzione della gravità. Ma non è la prima volta che si arriva a giustificare questa tesi. Il primo tentativo di dare un nome ai fenomeni spazio-temporali risale alla fine del Settecento. E non è ancora finita.

Gli scienziati che per primi misero in relazione la gravità newtoniana con la curvatura della luce, in prossimità di un oggetto massiccio, per esempio un pianeta, furono Henry Cavendish nel 1784 e Johann Georg von Soldner nel 1801; ma solo Albert Einstein fu in grado di calcolare il valore esatto di questo fenomeno. In particolare lo scienziato svizzero, con la sua teoria della Relatività, predisse due fenomeni: l'effetto geodetico, vale a dire l'“avvolgimento” dello spazio-tempo attorno a una massa gravitazionale, e l'effetto di trascinamento, frame-dragging, inerente l'interrelazione fra corpi in rotazione e alterazioni spazio-temporali. Oggi questi due fenomeni sono stati ufficialmente confermati dalla missione NASA Gravity Probe B, dopo sei anni di sperimentazione. «Immaginiamo la Terra come immersa nel miele», spiega Francis Everett, fisico della Stanford University. «Quando il pianeta ruota su se stesso, o si muove attorno al Sole, nel miele si formano dei vortici. Ebbene, questo miele conferma l'esistenza dello spazio-tempo». Per ottenere questi risultati sono stati utilizzati quattro giroscopi, montati su una sonda, puntati sulla stella IM Pegasi, nella costellazione di Pegaso. Oggetti di questo tipo consentono analisi ultra-precise; la loro sensibilità è, infatti, del milliarcosecondo, che corrisponde alla stima dello spessore di un foglio di carta osservato da una distanza di circa 160 chilometri. Concetto chiave dello studio: la gravità, ossia la più debole (ma non per questo meno importante) delle quattro forze fondamentali che regolano il creato. Secondo gli scienziati se la gravità non influisse sullo spazio-tempo, i giroscopi avrebbero puntato i loro occhi sempre nella stessa direzione, e invece s'è visto che gli strumenti sono in grado di misurare dei piccoli cambiamenti nella direzione delle loro rotazioni, provando che la gravità terrestre agisce sullo spazio-tempo. «Gravity Probe B ha confermato due delle più profonde previsioni di Einstein», prosegue Everett, «che hanno grandissime implicazioni in tutto il campo della ricerca astrofisica. Allo stesso modo, le innovazioni tecniche dietro questa missione lasciano una grande eredità, sia per quanto riguarda la Terra che lo spazio». Gravity Probe B (GP-B) è il nome di una missione effettuata con un satellite lanciato il 20 aprile 2004 con lo scopo di misurare la curvatura dello spazio-tempo in prossimità della Terra, e contemporaneamente il cosiddetto “tensore energia impulso”, legato alla distribuzione della materia nella spazio. L'idea risale al 1963, ma solo ora è stato possibile attuarla. La ricerca ha coinvolto 86 dottorandi della Stanford University, altri 14 provenienti da diversi atenei internazionali, centinaia di studenti di cinquantacinque high school, l’astronauta Sally Ride e il premio Nobel Eric Cornell.

Non è comunque la prima volta che si arriva a giustificare approfonditamente l'universo einsteniano. La prima prova risale al 1915, quando la teoria di Einstein fu in grado di prevedere con precisione l'entità della precessione del perielio di Mercurio; tenendo conto del fatto che, il punto in cui il primo pianeta del Sistema Solare passa più vicino alla nostra stella (detto, appunto, perielio), è ogni anno leggermente in anticipo. Prima si giustificava questo anticipo con la presumibile esistenza di un altro pianeta all'interno dell'orbita mercuriana. Poi, proprio grazie alla Relatività, s'è capito che i secondi d'arco che precedono secolarmente il cammino di Mercurio, sono il risultato della forza gravitazionale espressa dagli altri pianeti.

A un risultato analogo sono giunti gli esperti dell'Istituto di Fisica dello Spazio Interplanetario di Roma. In questo caso per spiegare la precessione relativistica di un'orbita, gli scienziati italiani hanno studiato il peregrinare nel cosmo di LAGEOS II, un satellite costruito alla fine degli anni Ottanta e lanciato nello spazio nel 1992. Sono così giunti a verificare che l'orbita di un corpo attorno a un altro non rimane fissa nel cosmo, come asserisce la meccanica classica, ma subisce uno spostamento continuo. Anche questa ricerca, dunque, prova che la relatività è corretta. In seguito s'è potuto accertare che la precessione di un satellite è dovuta alla somma di tre effetti. Il primo – analogo a quello emerso dal Gravity Probe B Project – è dovuto alla curvatura dello spazio-tempo prodotta dalla massa terrestre; il secondo è conseguenza della deformazione dello spazio-tempo provocata dal nostro pianeta; il terzo è causato da una deformazione dello spazio-tempo che si origina dal moto della Terra attorno al Sole. «L’analisi finale ha fornito una discrepanza con la predizione della relatività generale dello 0.2%», dichiarano gli scienziati italiani. «In altri termini la misura conferma la Relatività con una precisione del 99.8%».

A riprova delle teorie einsteniane si sono avuti interessanti risultati anche dalla sonda Cassini-Huygens, lanciata dal Centro Spaziale Kennedy il 15 ottobre 1997. Si è, infatti, riusciti a misurare con buona precisione la curvatura e il ritardo di onde elettromagnetiche nella vicinanza di grandi masse. A simili considerazioni, in realtà, s'era già giunti nel 1919, quando un team di studiosi della Royal Astronomy Society, fotografando delle stelle durante un'eclissi solare, dimostrò che gli astri risultano spostati rispetto alla loro corretta posizione. Il fenomeno spiega il motivo per cui la luce delle stelle in vicinanza del Sole, non procede più in linea retta ma, segue una curva di circa 1,7 secondi di arco, sfalsando la vera posizione stellare.

giovedì 4 agosto 2011

L'agonia del lago d'Aral

|

| Là dove c'era il lago ora c'è... il deserto |

Il lago d'Aral, un tempo il quarto bacino lacustre del mondo, rischia di scomparire dagli atlanti geografici entro il 2020. Stando, infatti, alle recenti ricostruzioni compiute dall'ESA, negli ultimi decenni la distesa d'acqua dolce s'è ristretta del 74% e il suo volume si è ridotto dell'85%. La fase di prosciugamento, iniziata negli anni Sessanta, ha portato allo sviluppo di due specchi lacustri: il piccolo Aral, a nord, e il grande Aral, a sud. Ma mentre per la parte meridionale non c'è più nulla da fare, gli ambientalisti confidano di riuscire almeno a salvare il bacino settentrionale: a questo scopo è stata creata una diga per separare definitivamente le due porzioni lacustri e per consentire a un vecchio immissario di alimentare il piccolo Aral. Il declino del lago posto a cavallo fra Uzbekistan e Kazakistan, sopraggiunge con la sciagurata idea dell'establishment sovietico di coltivare intensamente le piantagioni di cotone, sfruttando le acque dei fiumi Amu Darya e Syr Darya, che dalla notte dei tempi tengono in vita il bacino. Prima di questo intervento la superficie lacustre misurava 67mila chilometri quadrati; la popolazione in prossimità del lago beneficiava di prodotti ittici e di un clima mitigato dal ciclico movimento delle acque; Muynak, il vecchio centro affacciato sulle sue rive, rappresentava uno dei porti più floridi della regione ed era fra le mete turistiche più gettonate dagli amministratori dell'epoca. Ma oggi la situazione è drasticamente cambiata. Le persone che vivono nei dintorni del lago, infatti, oltre a patire la fame, sono vittime di numerosi disturbi, soprattutto a livello respiratorio, per via delle polveri alzate dal vento, cariche di sale e di pesticidi. L'80% delle specie ittiche è estinta. E Muynak è divenuta una specie di città fantasma, mezza sepolta dalla sabbia, circondata da navi arrugginite e altri relitti marittimi.

|

| Le fasi di prosciugamento del lago |

Un ulteriore problema deriva dall'isola Vozrozdenia, antica sede di esperimenti condotti con armi batteriologiche. Benché nel 2002 gli statunitensi siano intervenuti per disinfestare il territorio, risulta che siano ancora presenti materiali potenzialmente pericolosi. Il rischio, dunque, è che animali e uomini possano venirne a contatto, causando disastri di natura sanitaria e ambientale. Secondo i dati forniti dal NASA World Wind, la situazione è già precipitata, poiché l'isola si sarebbe ormai trasformata in una penisola. Ma Google Earth e Google Maps contraddicono questa tesi, sostenendo che Vozrozdenia sia ancora separata dalla terraferma da qualche centinaio di metri. Evidentemente la bassezza dei fondali confonde le idee, ma è chiaro che l'isolamento della lingua di terra nel cuore dell'Aral ha i giorni contati.

|

| Immagine aerea del lago d'Aral: si nota sulla destra l'isola Vozrozdenia |

lunedì 1 agosto 2011

Più intelligenti di così...

Più intelligenti di così non si può? È la domanda emersa da uno studio condotto da esperti dell'Università di Cambridge. Stando, infatti, alle conclusioni degli scienziati l'uomo ha raggiunto il suo apice evolutivo, oltre il quale – almeno intellettualmente parlando – non può più andare. Dalle forme australopitecine risalenti a oltre 3 milioni di anni fa, il cervello dell'uomo è andato continuamente aumentando di dimensioni, ma ora il processo è bloccato, anzi, potrebbe addirittura assumere l'andamento opposto. Il motivo? Dovremmo consumare troppa energia per aumentare ulteriormente la nostra intelligenza, cosa che non può avvenire perché occorrerebbe più “spazio in testa”. La tesi è curiosa ma lascia molti dubbi. In realtà s'è sempre pensato che in un modo o nell'altro l'evoluzione umana progredirà, senza sapere nei dettagli cosa potrà accadere e in che modo il cervello umano potrà differenziarsi da quello che è oggi. L'ennesima boutade scientifica? Forse. Ma intanto gli scienziati di Cambridge si assumono tutte le responsabilità del caso affermando che il nostro cervello, pur pesando solo il 2% del corpo, consuma il 20% dell'energia. È già troppo. «Per profonde capacità di deduzione serve molta energia al nostro cervello», rivela Simon Laughlin, professore di neurobiologia. «Deve quindi trovare collegamenti fra informazioni che vengono da fonti anche completamente diverse. Tutto ciò indica che c'è un limite alla quantità di notizia che possiamo elaborare». Anche la miniaturizzazione delle cellule neuronali e l'incremento delle connessioni fra le cellule del cervello, sarebbero arrivati al limite. Insomma non ci sono più margini di miglioramento. E adesso? Risponde Martijn van den Heuvel, docente di psichiatria del centro clinica di Utrecht: «Per aumentare il potere del cervello servirebbe, in effetti, un aumento di energia, tuttavia fare previsioni su un futuro remoto è rischioso, benché sia chiaro a tutti che ci sono forti limiti a un ulteriore sviluppo».

Iscriviti a:

Post (Atom)

-

Oggi praticamente ogni organo può essere trapiantato, consentendo la sopravvivenza (anche di molti anni) di individui altrimenti spacciati. ...

-

La maggior parte delle persone, quando parla al telefono o partecipa a una riunione, se ha a disposizione un foglio bianco e una biro, si ri...

-

Adamo: 930 anni. Set: 912. Noè: 950 anni. Matusalemme: 969 anni... Sono gli anni che avevano alcuni dei più importanti personaggi della Bibb...